当业界普遍认为AI大模型市场已被科技巨头及其合作伙伴瓜分完毕时,一家仅有30人的初创公司却用一款4000亿参数的永久开源基础模型,向这一格局发起了有力挑战。最新行业动态指出,这款名为Trinity的模型不仅规模惊人,更在多项基准测试中展现出与行业顶尖模型一较高下的潜力,为开发者社区提供了一个全新的、不受商业条款限制的开源大模型选择。

Trinity模型的核心突破与性能表现

市场消息显示,Arcee AI最新发布的Trinity模型拥有4000亿参数,使其成为由美国公司训练和发布的最大规模开源基础模型之一。该模型采用了宽松的Apache 2.0许可证,这意味着其代码和权重将永久保持开源,任何个人或企业均可自由使用、修改和分发。

在性能方面,根据该公司提供的基准测试数据(基于基础模型,极少后训练),Trinity在编程、数学、常识推理和知识问答等多个关键领域,其表现已与Meta的Llama 4 Maverick 400B以及来自中国的GLM-4.5等高性能开源模型处于同一梯队。尤其值得注意的是,在部分编程和数学推理任务上,Trinity甚至略有优势。

目前,Trinity模型专注于文本处理。不过,熟悉内情的人士透露,其多模态版本已在开发路线图上,包括视觉模型和语音转文本功能,旨在未来提供更全面的AI能力。

“小团队,大野心”:极速低成本的模型训练奇迹

更令人惊讶的是其背后的开发故事。该公司在一份最新文件中披露,整个Trinity模型家族(包括此前发布的26B参数Mini版和6B参数Nano版)的全部训练工作仅在六个月内完成,总成本约为2000万美元。这一效率在动辄耗费数亿甚至数十亿美元的大模型训练领域堪称奇迹。

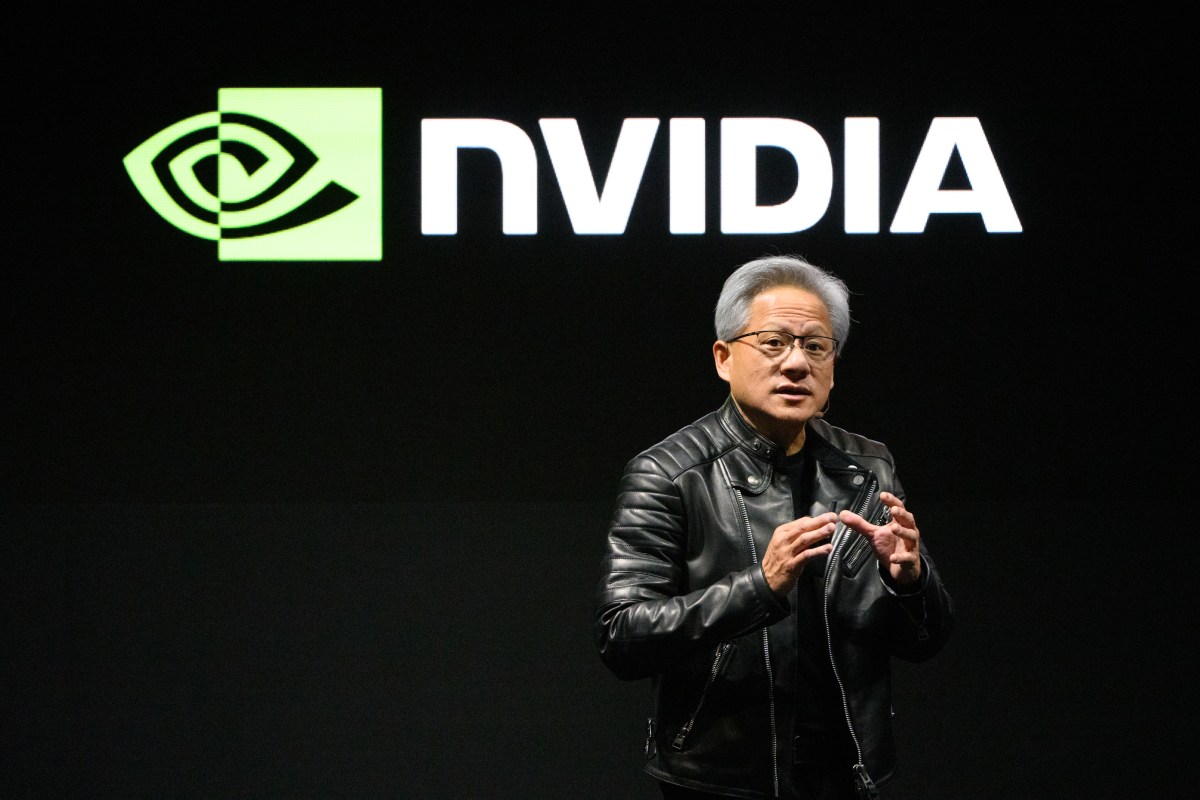

技术团队使用了2048块Nvidia Blackwell B300 GPU集群完成了这一壮举。该公司联合创始人兼CTO表示,这笔资金对一家初创公司而言是巨大的投入,但相比大型AI实验室的预算仍相形见绌。成功的秘诀在于一支“极度饥渴”的年轻研究团队,他们抓住了这次机会,通过无数个不眠之夜将不可能变为可能。

从模型定制商到AI实验室的战略转型

Arcee AI的转型之路颇具代表性。该公司最初并非一家AI实验室,而是一家为SK Telecom等大型企业客户提供模型定制化和后训练服务的公司。他们会基于Llama、Mistral、Qwen等现有的开源模型,通过强化学习等技术对其进行优化,以满足客户的特定需求。

然而,随着业务发展和对供应链安全的担忧,自主研发前沿基础模型逐渐成为公司的战略必需。同时,市场上许多性能优异的开源模型来自中国,这使许多受政策限制或心存顾虑的美国企业难以采用。因此,打造一个“美国本土的、永久开源的、前沿级”的替代方案,成为了Arcee AI的核心使命。

“永久开源”的承诺与商业布局

Arcee AI将Trinity定位为对现有“伪开源”生态的一次修正。该公司指出,一些主流开源模型(如Llama)使用的是由原公司控制的许可证,附带商业和使用限制,这并不符合真正的开源精神,甚至被部分开源组织认为不完全合规。

“要赢得开发者的心,你必须给他们最好的。”该公司CTO强调。为此,所有Trinity模型(大、中、小版本)均可免费下载。大型版本将提供三种形态:Trinity Large Preview(轻量后训练的指令微调模型)、Trinity Large Base(未经后训练的基础模型)以及TrueBase(剔除了所有指令数据和后训练影响的“纯净”基础模型,方便企业和研究者从头定制)。

在商业模式上,除了免费开源,该公司也将提供具有竞争力的API服务。目前,Trinity Mini的API定价为每百万token输入0.045美元/输出0.15美元,并提供限速免费层级。公司原有的模型后训练和定制化服务也将继续。

行业影响与未来展望

Arcee AI的这次发布,为开源AI生态注入了新的活力。它证明,在巨头林立的AI竞赛中,拥有清晰战略、顶尖人才和高效执行力的初创公司,依然有机会在基础模型这一核心战场发出自己的声音。

从行业角度看,Trinity的出现至少带来了三重影响:首先,它为用户,特别是企业和学术机构,提供了一个真正自由、无后顾之忧的开源大模型选项,降低了技术依赖风险。其次,其极致的训练效率为行业树立了新的成本控制和技术管理标杆。最后,它加剧了开源模型领域的竞争,有望推动整个生态在性能、开放度和易用性上持续进步。

未来,随着Trinity多模态能力的完善和推理训练的加强,它能否在更广泛的任务中达到甚至超越现有SOTA模型,将成为观察其长期价值的关键。无论如何,这家小公司的“大模型”梦想,已经为AI开源世界的未来增添了更多可能性。

相关文章