为何Cohere前人工智能研究主管不看好规模竞赛

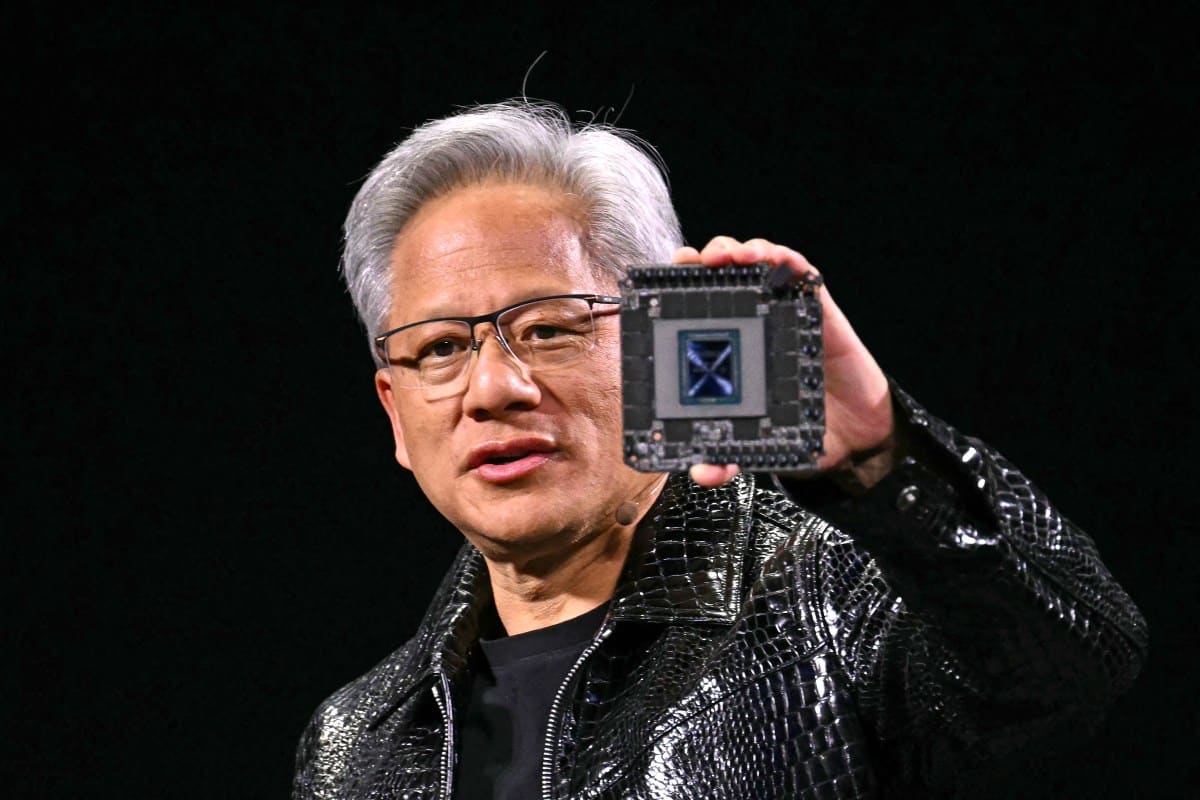

AI实验室竞相建造曼哈顿规模的数据中心

全球人工智能实验室正竞相建造规模堪比曼哈顿的数据中心,每个项目耗资数十亿美元,能耗相当于小型城市。这股建设热潮源于对“规模扩展”理论的深信不疑——该理论认为只要持续为现有AI训练方法增加算力,终将培育出能执行各类任务的超智能系统。

规模扩展遭遇瓶颈

然而越来越多AI研究人员指出,大语言模型的规模扩展可能已接近极限,要提升AI性能可能需要其他技术突破。这正是Cohere前AI研究副总裁、谷歌大脑校友萨拉·胡克通过其新创公司Adaption Labs押注的方向。

今年8月离开Cohere的胡克与同事苏迪普·罗伊共同创立了这家公司,其核心理念是:通过扩大模型规模来提升AI性能已成为低效路径。胡克在本月悄然宣布启动该项目,开始大规模招募人才。

自适应学习的新路径

胡克在接受TechCrunch采访时表示,Adaption Labs正在开发能够持续适应现实环境并从经验中高效学习的AI系统。她拒绝透露具体技术细节,也未说明公司是否依赖大语言模型或其他架构。

“我们正处在转折点,单纯扩大模型规模的路径虽然诱人却极其乏味,至今未能产生真正理解世界并与世界互动的智能体。”胡克指出,“自适应才是学习的核心。”

她以生活场景举例:当你的脚趾撞到餐桌时,下次经过就会更小心。AI实验室曾尝试通过强化学习实现这种学习机制,让模型在受控环境中从错误中学习。但现有强化学习技术无法帮助已投入商用的AI系统实时从错误中学习,导致系统会反复犯同样错误。

定制化服务的高门槛

部分AI实验室提供定制化模型优化服务,但价格高昂。据报道,OpenAI要求客户至少投入1000万美元才能获得模型微调咨询服务。

胡克批评道:“目前由少数前沿实验室决定AI模型的统一服务模式,调整成本极其昂贵。事实上,AI系统本应能高效地从环境中学习。证明这一点将彻底改变AI控制权和塑造权的格局,最终决定这些模型为谁服务。”

行业风向转变

Adaption Labs的成立标志着行业对扩展大语言模型的信心正在动摇。MIT研究人员最新论文指出,全球最大AI模型可能很快出现收益递减。旧金山AI圈的氛围也在转变,知名播客主德瓦克什·帕特尔近期与著名AI研究者的对话中流露出不同寻常的质疑态度。

被誉为“强化学习之父”的图灵奖得主理查德·萨顿9月表示,大语言模型因缺乏现实经验学习能力而无法真正扩展。OpenAI早期员工安德烈·卡帕西本月也表达了对强化学习长期潜力的保留意见。

历史警示与当前突破

这类担忧并非首次出现。2024年末就有研究人员警告,通过预训练扩展AI模型的做法已触及收益递减拐点——而预训练正是OpenAI和谷歌提升模型性能的秘诀。

虽然预训练的收益递减已体现在数据中,但行业找到了新突破点。2025年,AI推理模型通过额外计算时间解决问题,将模型能力推向新高度。

新方向的高成本挑战

AI实验室现在坚信扩展强化学习与推理模型是新的前沿。OpenAI研究人员曾透露,其首款推理模型o1的开发正是看中其良好的扩展性。Meta与Periodic Labs近期发布的研究报告探讨了如何通过强化学习进一步提升性能——这项耗资超400万美元的研究凸显了现有技术路线的昂贵本质。

Adaption Labs的雄心

相比之下,Adaption Labs旨在找到下一代突破技术,证明经验学习可以大幅降低成本。据三位审阅过其融资材料的投资者透露,今秋早些时候该公司正洽谈2000万至4000万美元的种子轮融资,目前本轮融资已结束但具体金额未公开。胡克拒绝对此置评。

被问及投资者时,胡克表示:“我们的定位就是追求极致雄心。”她此前领导Cohere Labs时曾为企业应用训练小型AI模型。目前紧凑型AI系统在编程、数学和推理测试中已经常超越大型模型,胡克希望继续推进这一趋势。

胡克还以推动AI研究全球普及闻名,曾从非洲等代表不足地区招募研究人才。虽然Adaption Labs将在旧金山设办公室,但她表示计划在全球范围招聘。

范式变革的潜力

若胡克团队对规模扩展局限性的判断正确,将产生深远影响。目前已有数百亿美元投入大语言模型扩展,其前提假设是模型越大越接近通用智能。但真正的自适应学习不仅可能更强大,还有望实现更高效率。

玛丽娜·特姆金参与报道

相关文章