人工智能领域的算力军备竞赛进入新阶段。最新行业动态指出,AI巨头OpenAI已与芯片设计公司Cerebras达成一项价值超过100亿美元、为期数年的战略合作协议。根据协议,Cerebras将从今年起至2028年,为OpenAI提供总计高达750兆瓦的专用计算能力。这笔交易不仅是AI基础设施领域有史以来规模最大的订单之一,更可能预示着高端AI芯片市场格局的深刻变革。

从“推理延迟”到“实时交互”:百亿订单背后的技术野心

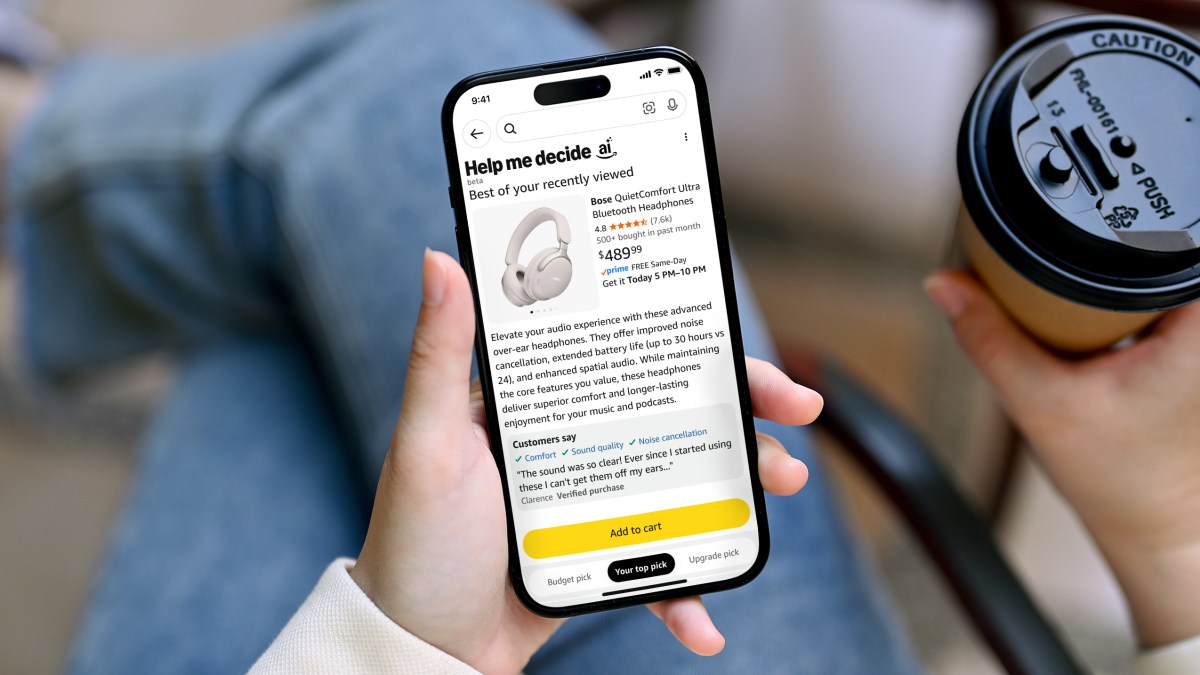

市场消息显示,这笔巨额交易的核心目标直指当前大模型应用的最大瓶颈之一:推理延迟(Inference Latency)。推理是指训练好的AI模型处理新数据并生成响应的过程,其速度直接决定了用户体验。OpenAI在一份官方声明中强调,引入Cerebras的系统旨在“显著加速那些目前需要更长时间处理的响应”。Cerebras联合创始人兼CEO安德鲁·费尔德曼更是将这一合作比作“宽带对互联网的变革”,并断言“实时推理将彻底改变AI”。

Cerebras的崛起与2022年ChatGPT引发的AI浪潮紧密相关。该公司以其独特的晶圆级引擎(Wafer Scale Engine, WSE)芯片闻名,该芯片专为AI工作负载设计,其核心面积远超传统GPU。Cerebras声称,其基于WSE芯片构建的系统,在处理某些AI任务时,速度远超基于GPU(如图形处理器)的系统,后者目前由英伟达(Nvidia)主导市场。

Cerebras的进击之路:从挑战者到关键供应商

尽管Cerebras在2024年已提交IPO申请,但其上市计划多次推迟。在此期间,该公司持续获得大规模融资。就在本周,有熟悉内情的人士透露,Cerebras正洽谈以220亿美元估值再融资10亿美元。一个值得关注的背景是,OpenAI的CEO萨姆·阿尔特曼本人已是Cerebras的投资者,且OpenAI曾一度考虑收购这家公司,凸显了双方深厚的战略纽带。

OpenAI基础设施战略负责人萨钦·卡蒂在声明中阐述了其算力布局思路:“OpenAI的计算战略是构建一个弹性的组合,将合适的系统匹配到合适的工作负载上。Cerebras为我们的平台增加了一个专用的低延迟推理解决方案。这意味着更快的响应、更自然的交互,以及为更多人扩展实时AI的更坚实基础。”

行业影响与未来展望:AI芯片战局再起波澜

这笔百亿美元订单的深远影响远超交易本身。首先,它标志着AI巨头开始“去英伟达化”,积极构建多元化的算力供应链,以降低对单一供应商的依赖并优化成本。其次,它验证了专用AI推理芯片市场的巨大潜力。随着AI应用从训练转向大规模部署,对高效、低成本推理算力的需求将呈爆炸式增长。

对于整个行业而言,OpenAI与Cerebras的结盟可能加速AI芯片市场的创新与竞争。长期以来,英伟达凭借其CUDA生态和强大的GPU产品线几乎垄断了高端AI训练市场。但Cerebras等公司从架构创新切入,专注于推理等特定场景,正在开辟新的战场。未来,我们可能会看到更多AI公司采用“混合架构”,即用英伟达GPU进行训练,而用Cerebras等专用芯片进行大规模推理部署。

这场百亿合作不仅关乎两家公司的未来,更可能重塑全球AI算力的权力版图,推动AI应用更快地走向实时化、普及化。对于开发者与企业用户来说,更高效、更便宜的推理能力意味着更强大的AI应用将成为可能。

相关文章