在AI模型训练成本高企、推理(Inference)成为运营成本核心的当下,科技巨头正通过自研芯片寻求破局。最新行业动态指出,微软已正式推出其第二代AI推理专用芯片Maia 200,性能较前代实现大幅跃升,旨在为运行当今最大规模的AI模型提供强大且高效的算力支持,并直接对标亚马逊、谷歌等竞争对手的自研方案。

性能飞跃:专为大规模AI推理而生

市场消息显示,Maia 200芯片集成了超过1000亿个晶体管,其计算能力实现了显著提升。该芯片在4位精度(4-bit precision)下可提供超过10 PetaFLOPS(每秒千万亿次浮点运算)的算力,在8位精度下也拥有约5 PetaFLOPS的性能。这意味着,单个Maia 200计算节点就能轻松驱动当前最庞大的AI模型,并为未来更复杂的模型预留了充足的性能空间。

AI推理是指使用已训练好的模型来处理新数据并生成结果的过程,与训练过程相比,它更侧重于实时、高效的响应。随着AI服务的大规模商业化,推理所产生的计算成本和能耗已成为企业运营的关键负担。因此,像Maia 200这样专为推理优化的芯片,其核心价值在于降低单位计算成本、提升能效比,并最终让AI服务更稳定、更经济。

巨头博弈:自研芯片成“去英伟达化”关键路径

微软推出Maia系列芯片,是科技巨头减少对英伟达(NVIDIA)GPU依赖大趋势下的关键一步。目前,谷歌拥有张量处理单元(Tensor Processing Units, TPUs),亚马逊则推出了Trainium系列AI加速芯片。这些自研芯片的共同目标是,在云端计算任务中分流原本完全由英伟达GPU承担的工作负载,从而优化整体硬件成本结构并掌握技术主动权。

据该公司在一份最新文件中披露的性能对比,Maia 200在关键指标上展现了竞争优势:其FP4性能据称是亚马逊第三代Trainium芯片的3倍,FP8性能也超过了谷歌的第七代TPU。这场围绕定制化AI芯片(Custom AI Silicon)的竞赛,正从根本上重塑全球AI算力市场的格局。

生态布局:从内部赋能到开放协作

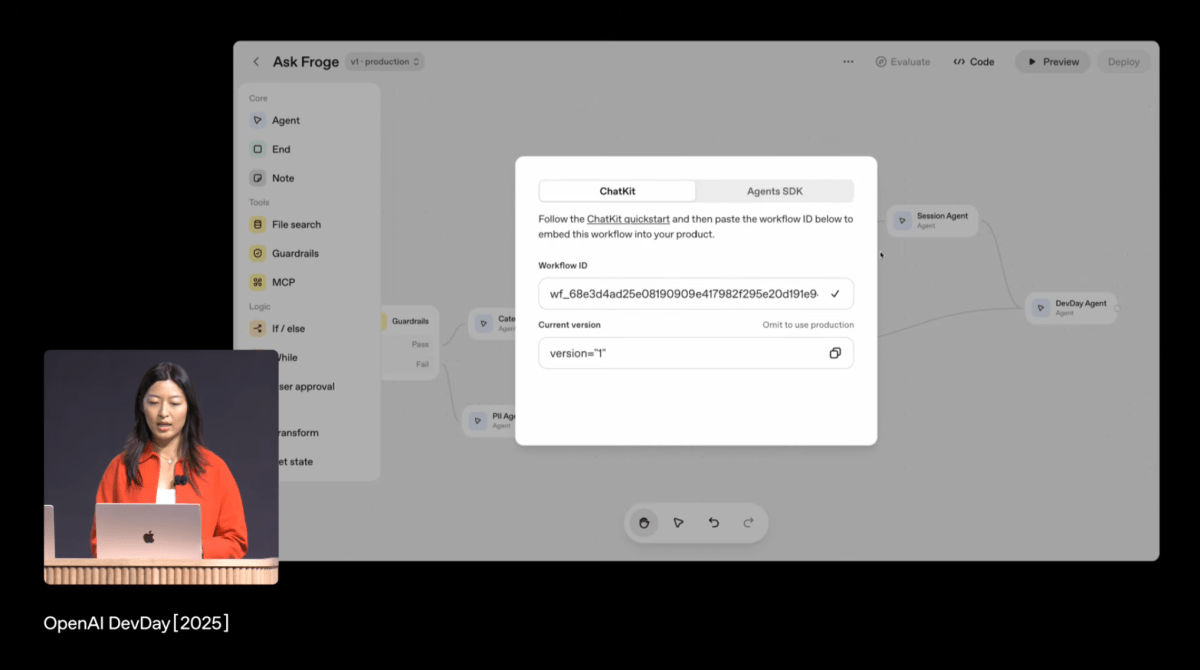

据悉,Maia芯片已深度集成于微软自身的AI业务中。它不仅为微软内部的前沿AI研究团队提供算力,更是支撑Copilot等AI助手服务的核心引擎。为了加速生态构建,微软已开始向部分开发者、学术机构和前沿AI实验室提供Maia 200的软件开发工具包(SDK),邀请他们在其工作负载中进行测试和应用。

这一举措表明,微软的野心不止于内部降本增效,更希望将Maia打造为一个开放的、具有行业影响力的AI算力平台,与现有的GPU和云服务形成互补。

行业影响与未来展望

微软Maia 200的发布,标志着AI基础设施竞赛进入了一个新阶段。从依赖通用GPU到开发专用推理芯片,反映出行业对AI商业化落地中成本、效率与可控性的极致追求。对于企业用户而言,巨头间的竞争有望带来更多元、更具性价比的算力选择,加速AI应用的普及。

长远来看,自研芯片的成熟将促使云服务商的AI服务更加差异化,并可能催生新的软硬件协同优化范式。然而,这也对软件栈的兼容性和开发者的适配能力提出了更高要求。无论如何,AI算力正从“通用时代”迈向“专用时代”,而像Maia 200这样的芯片,正是这场深刻变革中的关键推手。

相关文章