开源大模型全面解析:从概念到实践

在人工智能迅猛发展的今天,大型语言模型已成为推动技术进步的重要力量。特别是开源大模型的出现,正在打破技术壁垒,让更多开发者和企业能够接触并应用这一前沿技术。本文将深入探讨开源大模型的核心概念、技术原理、生态系统以及实际应用,为读者提供一个全面而深入的理解。

什么是开源大模型?

开源大模型是指源代码、模型架构、权重参数及训练数据全部或部分公开可用的大型人工智能模型。这些模型通常基于深度学习技术,拥有数十亿甚至数千亿参数,能够理解和生成人类语言、代码、图像等多种类型的内容。

与传统闭源模型相比,开源大模型具有透明度高、可定制性强、社区驱动等特点。任何人都可以下载、使用、修改和分发这些模型,无需支付昂贵的授权费用。这种开放性极大地促进了人工智能技术的普及和创新。

开源大模型的核心技术原理

Transformer架构

绝大多数现代大模型都基于Transformer架构,这一架构由Google在2017年首次提出。Transformer的核心创新是自注意力机制,它允许模型在处理输入序列时,能够同时关注序列中的所有元素,并根据它们的重要性分配不同的注意力权重。

自注意力机制的计算过程可以简化为三个步骤:首先,将输入向量分别转换为查询向量、键向量和值向量;其次,计算查询向量与所有键向量的点积,获得注意力分数;最后,使用softmax函数对注意力分数进行归一化,并加权求和值向量得到输出。

预训练与微调

开源大模型的开发通常分为两个阶段:预训练和微调。

预训练阶段,模型在海量无标注文本数据上学习语言的统计规律和世界知识。这个过程需要巨大的计算资源和时间,但得到的基座模型已经具备了强大的语言理解和生成能力。

微调阶段,开发者使用特定领域的数据集对预训练模型进行进一步训练,使其适应特定任务或领域。常见的微调技术包括指令微调、人类反馈强化学习等,这些技术能够显著提升模型在特定任务上的表现。

模型量化与优化

为了在有限的计算资源上运行大模型,开源社区开发了多种模型压缩和优化技术。模型量化是将模型参数从高精度浮点数转换为低精度表示的过程,如将FP32转换为INT8或INT4,这可以显著减少模型的内存占用和计算需求,同时保持较高的性能。

主流开源大模型概览

LLaMA系列

Meta公司发布的LLaMA系列是开源大模型的重要里程碑。LLaMA模型采用标准的Transformer架构,但在训练数据和模型缩放方面进行了优化。从LLaMA到LLaMA 2,再到最新的LLaMA 3,这一系列模型在性能、安全性和多语言支持方面不断提升,成为了开源社区最受欢迎的基座模型之一。

BLOOM系列

BLOOM是由BigScience项目推出的开源大语言模型,拥有1760亿参数,支持46种人类语言和13种编程语言。BLOOM的显著特点是其多语言能力和完全开放的开发过程,来自全球各地的研究人员共同参与了模型的设计和训练。

Mistral系列

法国初创公司Mistral AI发布的Mistral系列模型以其卓越的性能和高效的架构设计引起了广泛关注。Mistral 7B虽然在参数量上相对较小,但在多项基准测试中超越了参数更多的模型,这得益于其创新的混合专家架构和分组查询注意力机制。

中国开源模型

中国企业和研究机构也推出了众多优秀的开源大模型,如阿里的Qwen、百度的ERNIE、智谱的ChatGLM等。这些模型在中文理解和生成方面表现出色,同时也在不断扩展多语言能力,为全球开源社区贡献了中国智慧。

开源大模型的生态系统

模型托管平台

Hugging Face已成为开源大模型生态的核心平台,提供了模型托管、数据集分享、演示空间等全方位服务。开发者可以轻松地在Hugging Face上发现、下载和使用数千个开源模型,大大降低了AI应用开发的门槛。

推理和服务框架

为了高效地部署和服务大模型,开源社区开发了多种推理框架。vLLM通过创新的注意力机制和PagedAttention技术,实现了高效的内存管理和推理加速。TensorRT-LLM则利用NVIDIA TensorRT优化模型在GPU上的推理性能。这些框架使得在消费级硬件上运行大模型成为可能。

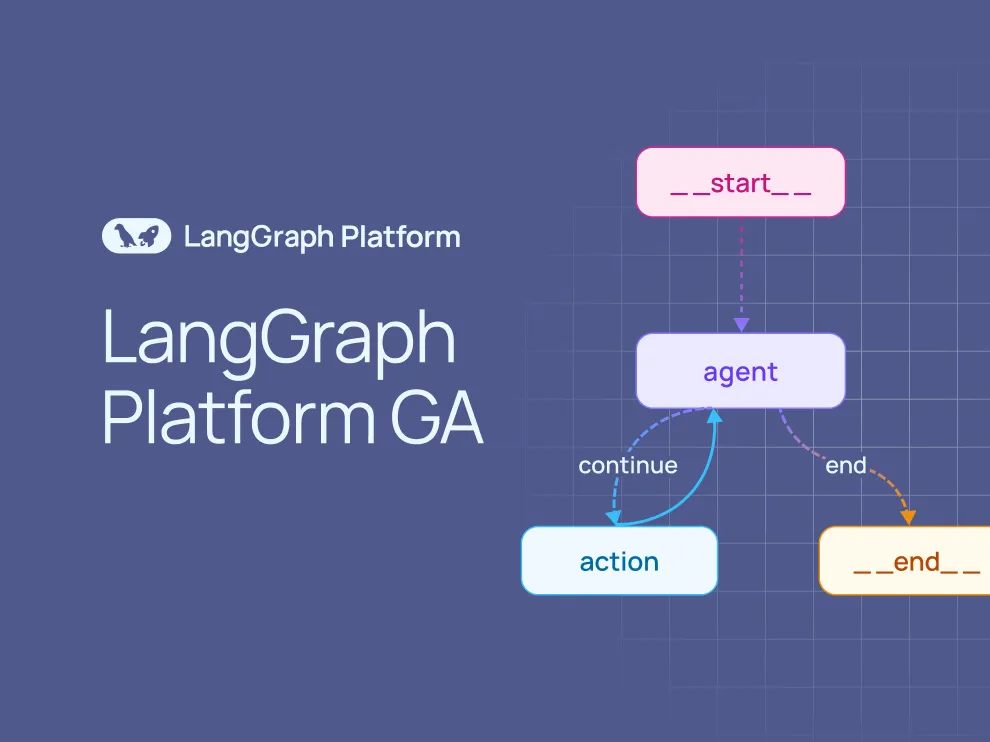

开发库和工具

围绕开源大模型,已经形成了丰富的开发工具链。PyTorch和Transformers库提供了模型加载和推理的基本能力;PEFT库实现了参数高效微调技术,允许开发者在有限资源下微调大模型;LangChain和LlamaIndex等框架则简化了基于大模型的应用程序开发流程。

开源大模型的实际应用

内容创作与编辑

开源大模型可以协助完成各种写作任务,如文章撰写、邮件起草、创意写作等。通过适当的提示工程和微调,模型能够适应不同的写作风格和内容要求,成为创作者的得力助手。

代码开发与调试

代码生成是开源大模型的重要应用场景。模型可以根据自然语言描述生成代码片段、完成代码补全、解释代码逻辑,甚至帮助调试程序错误。这显著提高了开发者的工作效率,降低了编程门槛。

数据分析与洞察

大模型能够理解结构化数据和自然语言查询,帮助用户从复杂数据集中提取有价值的信息。通过将模型与数据库和数据分析工具集成,可以构建智能的数据查询和可视化系统。

教育与培训

在教育领域,开源大模型可以充当个性化辅导教师,解答学生问题、提供学习资料、生成练习题和评估学习成果。这种一对一的教学方式能够满足不同学生的学习需求和节奏。

企业智能助理

企业可以基于开源大模型构建内部智能助理,处理客户咨询、支持员工工作、分析业务数据等。通过在企业内部数据上微调模型,可以确保其掌握领域专业知识,提供准确可靠的协助。

开源大模型的挑战与未来展望

当前面临的挑战

尽管开源大模型取得了显著进展,但仍面临诸多挑战。计算资源需求巨大,训练和推理成本高昂;模型可能存在事实错误、偏见和有害内容;知识产权和数据隐私问题也需要妥善解决;此外,如何评估模型能力、确保其安全可靠,仍是开放的研究课题。

未来发展趋势

开源大模型正朝着更小、更强、更专的方向发展。模型架构创新,如混合专家模型,能够在保持性能的同时大幅减少推理成本;多模态能力扩展,使模型能够同时处理文本、图像、音频等多种信息;个性化与自适应学习,让模型能够根据用户反馈不断改进;边缘计算部署,将大模型能力带入移动设备和物联网终端。

实践指南:如何开始使用开源大模型

对于想要尝试开源大模型的初学者,建议从以下步骤开始:

- 了解基础知识:学习深度学习和大语言模型的基本原理

- 选择适合的模型:根据硬件条件和应用需求选择合适的开源模型

- 搭建开发环境:配置Python环境,安装必要的库和框架

- 运行示例代码:从Hugging Face等平台下载模型并运行简单示例

- 尝试微调:使用自己的数据对模型进行微调,适应特定任务

- 部署应用:将训练好的模型集成到实际应用中

开源大模型正以前所未有的速度推动人工智能技术的民主化。随着技术的不断进步和生态的日益完善,我们有理由相信,开源大模型将在未来发挥更加重要的作用,为各行各业带来创新和变革。无论是研究者、开发者还是普通用户,现在都是深入了解和参与这一领域的绝佳时机。

相关文章