当AI学会拍电影:一文看懂视频生成新纪元

清晨的东京街头,一位穿和服的女子缓缓行走,樱花花瓣随风飘落——这个看似普通的视频片段,却没有任何真实摄像机参与拍摄。它完全由人工智能生成,从人物的微妙表情到光影的变化,全部来自算法的“想象”。

这就是AI视频生成技术带来的革命。它正在改变我们创造和消费视觉内容的方式,但背后的原理究竟是什么?

从文字到动态影像的魔法

想象一下,你向AI描述“一只熊猫在太空站里玩滑板”,几分钟后,一段十秒的视频就出现在眼前。这种看似魔法的技术,其实建立在复杂的算法和海量数据训练基础上。

目前的AI视频生成模型主要基于一种称为“扩散模型”的技术。它学习的过程就像一位画家学画——先观察成千上万的视频,学习如何从随机噪点中逐步“提炼”出清晰的图像和连贯的动作。

“可以把这过程理解为一种高级的联想学习,”斯坦福大学计算机教授李飞飞解释说,“模型通过学习数百万个视频样本,理解了现实世界中的运动规律、物理特性和因果关系。”

技术背后的科学原理

AI视频生成的核心是理解帧与帧之间的时空关系。当一个模型被训练时,它不仅仅学习单张图片的特征,更重要的是学习视频序列中物体如何移动、光线如何变化、表情如何过渡。

最新一代模型如Sora、Stable Video Diffusion等,采用了被称为“时空补丁”的技术。简单来说,AI将视频切分成许多小块,同时分析时间和空间两个维度的信息,就像同时观看多帧画面来理解动作的连贯性。

“这与人类理解运动的方式惊人地相似,”MIT神经科学教授Nancy Kanwisher指出,“我们的大脑也是通过整合连续视觉信息来感知运动的。”

能力与局限并存

当前的AI视频生成技术已经能够:

- 根据文本描述生成连贯的动态场景

- 将静态图片转化为动态视频

- 扩展现有视频的边界或时长

- 模仿不同的视觉风格和拍摄技法

然而,技术仍有明显局限。AI在理解复杂物理规则、保持长视频的连续性、描绘精细的手指动作等方面常常力不从心。你可能会看到水流违反重力、物体突然消失或人物手指数量不自然——这些都是当前技术的痛点。

应用前景与伦理思考

从娱乐产业到教育领域,AI视频生成技术正展现出巨大的应用潜力:

电影制作中,导演可以快速可视化场景概念;广告行业可以低成本制作多样化内容;教育工作者可以创建生动的历史场景复原。甚至个人用户也能轻松制作创意短片。

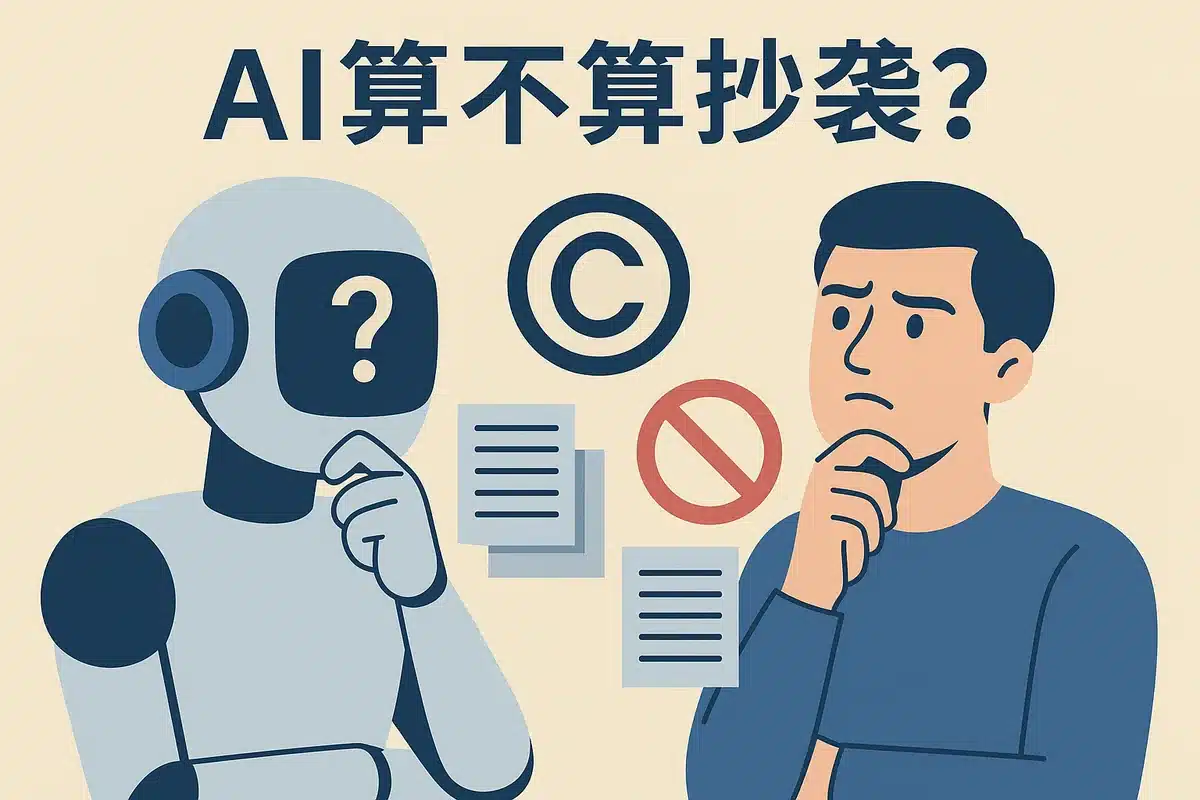

但技术同时也带来深刻的社会议题。深度伪造视频的检测、版权归属的界定、创意工作的未来,都是亟待解决的挑战。

“我们需要在技术创新和社会安全之间找到平衡,”人工智能伦理学者Sarah Dean认为,“这需要技术开发者、政策制定者和公众的共同努力。”

未来的方向

下一代视频生成模型正朝着更长时长、更高一致性、更强物理规律理解的方向发展。研究人员试图将世界模型引入视频生成,让AI不仅模仿视觉表象,更能理解背后的因果机制。

“未来的生成模型可能会发展出一种对世界的直觉理解,”OpenAI研究员Bill Peebles预测,“这不仅是多媒体创作的革命,更是通向更通用人工智能的重要一步。”

从文字到图像,再到动态视频,AI生成技术正以惊人的速度进化。它既是一项技术奇迹,也是一面镜子,映照出人类创造力与机器智能融合的无限可能。在这个新纪元里,我们不仅是技术的使用者,更是指引其发展方向的责任人。

相关文章